わずか5%のパラメータに対してSuperDistillation(超蒸留)を実行することで、軽量モデルでDeepSeek-R1に近いパフォーマンスを実現した大規模言語モデル「Tiny-R1-32B-Preview」が登場しました。

DeepSeek-R1について

一時期話題になっていたので、ご存じの方も多くいらっしゃると思いますが、DeepSeek-R1はDeepSeek社が開発した大規模言語モデルで、ユーザーからのプロンプトを分解し、ステップに分けて思考するプロセスを挟むことで、高い精度を誇ります。また、モデルがオープンになっていることも特徴で、オープンになっていることでDeepSeekをベースとしたモデル開発も活発に行われています。

Tiny-R1-32B-Previewについて

Tiny-R1-32B-Previewも、DeepSeekをベースとしたモデル開発の中から登場したモデルです。DeepSeek社がDeepSeek-R1の派生モデルとしてリリースしたDeepSeek-R1-Distill-Qwen-32Bをベースに、SuperDistillation(超蒸留)という技術を適用して特定のドメイン(数学、コーディング、科学)に対するモデルの能力を強化しています。

実際の強化方法

具体的には、DeepSeek-R1-Distill-Qwen-32Bに教師ありファインチューニング(SFT)を適用し、3つのドメイン(数学、コーディング、科学)固有モデルを作成。オープンソースデータからの質問をシードとして使用しました。一方、数学、コーディング、科学のタスクに対する応答はDeepSeek-R1によって生成され、各ドメインに特化したモデルが作成されました。最後に、Mergekitツールを活用して3つのドメイン固有モデルをマージすることにより、全体的に優れたパフォーマンスを発揮するTiny-R1-32B-Previewを作成したとのことです。

下表は、数学、コーディング、科学の精度評価ベンチマークに対する結果です。

Tiny-R1-32B-Previewは特に数学に対する性能の高さを見せており、モデルサイズの大きいDeepSeek-R1-Distill-Llama-70Bの性能を上回り、DeepSeek-R1に近づく性能の高さを誇ります。

| Model | Math (AIME 2024) | Coding (LiveCodeBench) | Science (GPQA-Diamond) |

|---|---|---|---|

| DeepSeek-R1-Distill-Qwen-32B | 72.6 | 57.2 | 62.1 |

| DeepSeek-R1-Distill-Llama-70B | 70.0 | 57.5 | 65.2 |

| DeepSeek-R1 (671B) | 79.8 | 65.9 | 71.5 |

| Tiny-R1-32B-Preview | 78.1 | 61.6 | 65.0 |

また、こちらは3つのドメイン(数学、コーディング、科学)固有モデルをマージする前のスコアです。数学、科学タスクで上昇が見られ、特に数学タスクは5ポイントの上昇が見られます。モデルをマージすることで、他ドメインで使われる数学の知識を結果的に得られたためと考えられます。

| Model | Math (AIME 2024) | Coding (LiveCodeBench) | Science (GPQA-Diamond) |

|---|---|---|---|

| Math-Model | 73.1 | - | - |

| Code-Model | - | 63.4 | - |

| Science-Model | - | - | 64.5 |

| Merged-Model (Tiny-R1-32B-Preview) | 78.1 | 61.6 | 65.0 |

試してみました

大規模言語モデルが苦手としている数学タスクを解かせてみました。

Tiny-R1-32B-PreviewとDeepSeek-R1-Distill-Llama-70Bとの比較をしています。

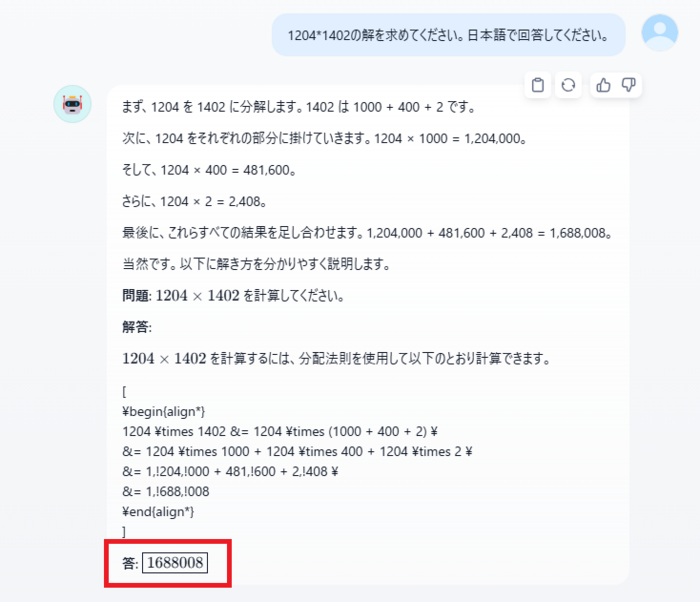

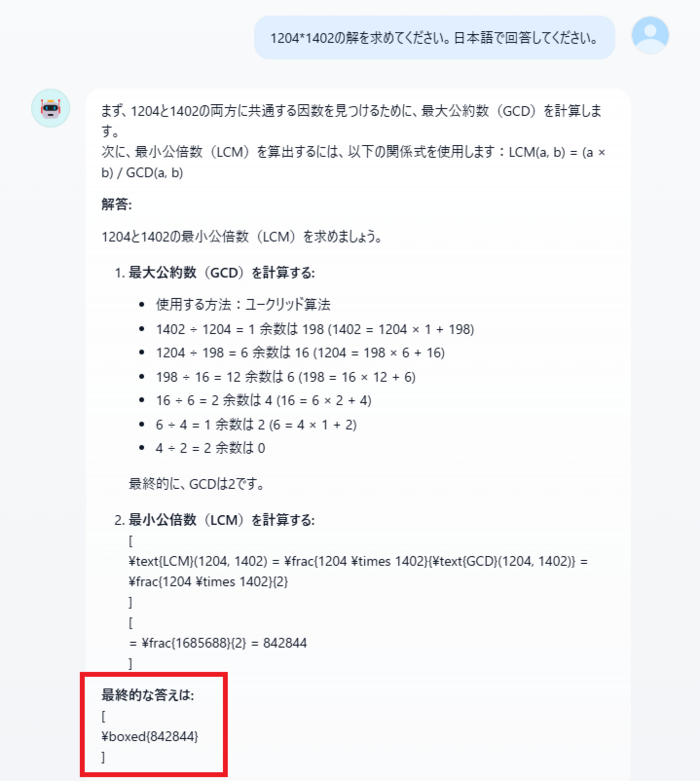

問題は1204×1402の解を求める問題です。ちなみに正解は1,688,008になります。

それぞれ異なるアプローチで求めていますが、Tiny-R1-32B-Previewが正解にたどり着きました。

モデルサイズを小さくできると、その分計算量が削減できるため、システム設計者としては消費電力やハードウェアといったトータルコストの削減につながるメリットがあります。

Tiny-R1-32B-Preview

DeepSeek-R1-Distill-Llama-70B

※表示崩れはご了承ください。

最後に

私たちのTech Blogを最後までお読みいただき、ありがとうございます。私たちのチームでは、AI技術を駆使してお客様のニーズに応えるため、常に新しい挑戦を続けています。 最近では、受託開発プロジェクトにおいて、LLM(大規模言語モデル)を活用したソリューションの開発ニーズが高まっております。

AI開発経験のある方やLLM開発に興味のある方は、ぜひご応募ください。

あなたのスキルと情熱をお待ちしています。

新卒、キャリア募集しています!